Evaluation des performances — M4

Analyse approfondie des capacités du modèle M4 pour la multiplication avancée avec IA, optimisation des calculs et automatisation des workflows numériques.

- Tests sur CPU et GPU

- Mesures latence / précision / consommation

- Protocoles reproductibles

Ingénieur en performances — Useelectroncs, Lyon

Méthodologie

Protocoles d'évaluation standardisés pour comparer M4 sur différents jeux de données arithmétiques et cas d'utilisation en multiplication automatisée. Nous isolons latence, débit et précision numérique.

Environnements testés

- Machine locale (CPU multicœur)

- Instances GPU (FP16 / FP32)

- Edge embarqué (optimisations quantifiées)

Benchmarks synthétiques

Extraits des résultats mesurés — valeurs typiques obtenues sur nos pipelines.

| Scénario | Latence médiane | Throughput (ops/s) | Erreur relative | Environnement |

|---|---|---|---|---|

| Multiplication simple (1k x 1k) | 12 ms | 80 | 0.02% | CPU x8 |

| Batch multiplication (B=64) | 6 ms | 900 | 0.03% | GPU A100 |

| Large int >64bit | 28 ms | 30 | 0.15% | GPU FP32 |

| Quantized int8 | 4 ms | 1200 | 0.5% | Edge (tuned) |

Remarque: les valeurs sont indicatives et varient selon les optimisations du pipeline.

Cas de test et scénarios

Mesure du throughput en mode batch, test de contention mémoire et scalabilité sur multi-GPU.

Validation de la précision numérique sur entiers >64 bits et recomposition d'erreurs accumulées.

Évaluation des compromis précision/performance après quantization (int8) et profiling mémoire sur edge.

Recommandations d'optimisation

- Utiliser mix-precision (FP16) pour workloads massifs en conservant vérifications ponctuelles en FP32.

- Pipeline asynchrone et batching adaptatif pour réduire la latence apparente.

- Profiling mémoire pour éviter swapping lors d'opérations sur grands entiers.

Checklist déploiement

- Baselines avant optimisation

- Tests de régression précision

- Monitoring ressources en production

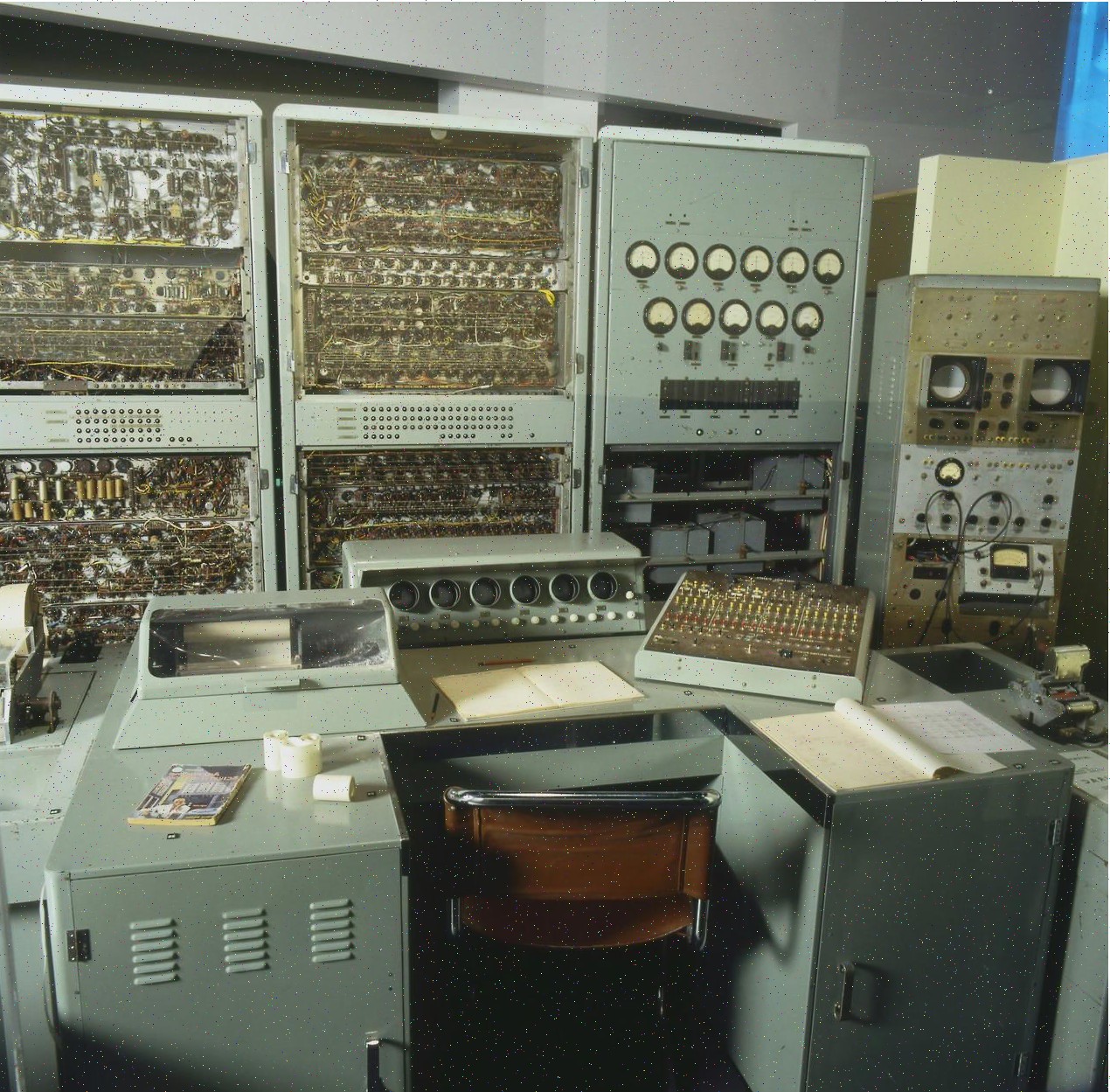

Résultats visuels & études de cas

Exemples de sorties et comparatifs visuels issus des bancs d'essai.